E' stato un anno rovente per il mercato delle schede video. Con AMD che ha rilasciato tutti i prodotti entro Aprile per ogni fascia di prezzo e Nvidia che ha preferito aggiudicarsi il primato prestazionale sulla fascia alta presentando a Febbraio la Gtx 680, primo modello della nuova architettura Kepler che ha messo subito in chiaro le cose. Consumi ridottissimi, nuove feature software (alcune disponibili anche per i precedenti chip Fermi) e soprattutto un'architettura interna rivista che ha raddoppiato le prestazioni di ogni singolo Streaming Multiprocessor (ora denominati eXtended).

Quindi pur riducendo il numero totale di SMX, la potenza di calcolo nuda e cruda è aumentata, permettendo a Nvidia di ottenere risultati eccezionali sia in ambito desktop che mobile. Tuttavia il territorio della più grande fascia di consumatori è stato senz'ombra di dubbio appannaggio della concorrente AMD. Almeno sino ad ora. Finalmente potremo mettere le mani sulle schede Kepler di fascia media: dopo la 660 Ti, giungono sul mercato anche la GTX 660 "liscia" e la GTX 650, pensate per completare l'offerta hardware della casa di Santa Monica. In attesa di una prova su strada, in questo articolo vi proponiamo una semplice analisi dei dati ufficiali che Nvidia ci ha gentilmente messo a disposizione.

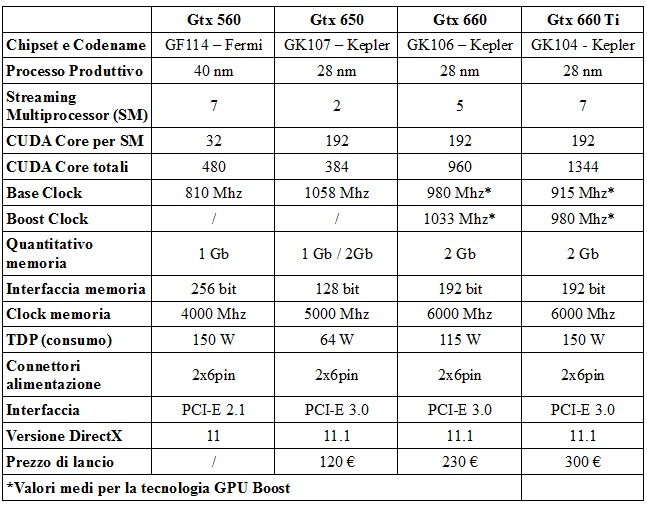

Caratteristiche tecniche

Dalle tabelle che potete visionare in questo articolo, emergono diversi dati interessanti che potrebbero porre le due schede sotto la confortante luce del successo. La pura conta degli Streaming Multiprocessor (le unità che di fatto costituiscono la forza bruta della GPU) rispetto alla serie 500 si allinea in proporzione con quanto abbiamo già visto per le 670 e 680. Essendo inferiori di numero, la nostra scheda riuscirà a calcolare meno istruzioni in parallelo che in precedenza, ma essendo invece i CUDA Core per ciascuno (le sotto unità di calcolo parallelo di una singola stringa di dati) triplicati due volte, in pratica il calcolo viene effettuato molto più velocemente.

Questo approccio, possibile anche grazie alla riduzione del processo costruttivo da 40nm a 28nm, è risultato vincente per le schede finora rilasciate e ha portato a un risparmio sui consumi davvero incredibile. Nel nostro caso la GTX 650, la scheda che per prestazioni sulla carta sembrerebbe più o meno equivalere alla "vecchia" 560, consuma soli 64 W a medio carico, meno della metà della soluzione passata. Come da prassi per l'high-tech, un minor consumo significa un più ampio margine di aumento delle prestazioni (leggasi clock), complice nel nostro caso l'abbassamento globale delle temperature delle schede. In sostanza, lasciando da parte i tecnicismi, Nvidia è riuscita ad aumentare la velocità delle sue proposte ben al di sopra delle aspettative con la 650, che viaggia ben solida sopra il GigaHertz. Un guadagno netto che aspetta solo di trovare conferma in accurati benchmark. Curioso invece che Boost e Base Clock della 660 siano superiori a quelli della 660 Ti, ma chi conosce l'architettura Kepler saprà già che si tratta di valori puramente indicativi. Anche le memorie godono ora di un clock più elevato, anche se i più smaliziati potrebbero aver notato che il bus dell'interfaccia passa da 256 a 192 bit (che volgarmente significa che i dati vengono trattati dalle schede in frammenti più corti che in precedenza). Vogliamo però rassicurare i lettori: già per le altre schede Nvidia di nuova generazione questo passo indietro non ha portato alcuno svantaggio e non vediamo perchè dovrebbe portarlo in questo caso. Più significativa invece l'assenza del GPU Boost per la 650 che torna ad avere un puro e semplice clock fisso. Come già saprete, il GPU Boost è la tecnologia proprietaria della casa di Santa Clara che permette alla scheda stessa di diminuire o aumentare la sua velocità a seconda del consumo richiesto per soddisfare i requisiti di calcolo del programma in esecuzione.

In sostanza è una specie di "overclock automatico" del tutto simile alla tecnologia Speedstep dei processori Intel di cambiamento di frequenza dinamico direttamente inserita nel kernel. I suoi vantaggi sono molteplici, soprattutto per chi non volesse cimentarsi in overclock diretti ed è un peccato non vederla inserita anche nella scheda di riferimento per la fascia prestazionale medio-bassa. Per ora invece non sappiamo nulla riguardo all'altra caratteristica importante pensata per la serie 600, ovvero l'Adaptive Vsync, che si è dimostrato molto efficace per prevenire lo stuttering all'esecuzione dei giochi più recenti (presentando tuttavia qualche problema nei videogame basati su engine più anziani, come Skyrim); né si hanno informazioni per quanto riguarda il TXAA, la nuova routine di Anti Aliasing che dovrebbe unire in modo intelligente il classico Multi Sampling al meno gradito FXAA (per ora sfruttata solamente dal discusso The Secret World). Riassumendo, tutto questo non sarà a disposizione dei possessori della scheda più economica, ma è invece ben presente dalla 660 "liscia" in su.

Per noi PC gamer

Dopo tutto questo gran parlare di processori, bus, istruzioni e dati, possiamo azzardare un semplice pronostico: la battaglia per la più ampia fetta di mercato è appena cominciata e la risposta di AMD siamo certi che non tarderà ad arrivare, almeno con un abbassamento dei prezzi.

Per ora le dirette concorrenti Radeon HD 7850 e 7870 parrebbero, sulla carta, rimanere allo stesso livello prestazionale e un'eventuale scelta del brand per il consumatore dipenderà ancora una volta dal mantra che sembra caratterizzare la corrente generazione di hardware video: preferite una maggior scalabilità e più feature tecniche con release dei driver più stabili, o una buona potenza risparmiando qualche decina di euro? Entrambe le scelte sono valide, ma vorremmo corroborare queste opinioni con i primi benchmark che potrete già trovare in giro per la rete mentre state leggendo queste righe e che per ora noi non abbiamo potuto effettuare. Bisogna sottolineare per concludere che Nvidia ha messo in atto una campagna di partnership con le maggiori software house che ha dell'incredibile.

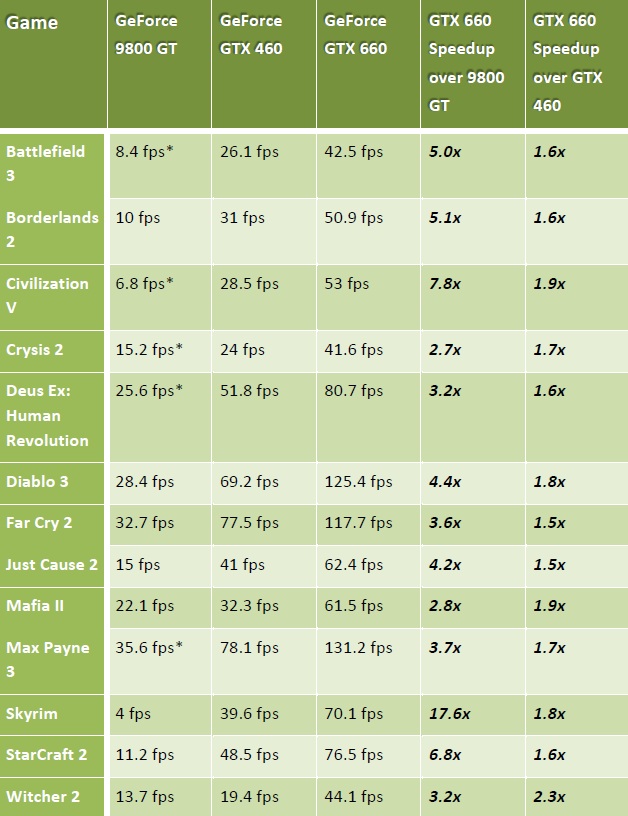

In pochi rapidi colpi, Gearbox, Rockstar, Crytek, DICE, Epic e Blizzard hanno implementato le nuove tecnologie di Santa Clara direttamente nei loro engine, con tanto di logo verde all'apertura del gioco che con suadente voce vi lancia alla disperata pressione del tasto per saltarla. Ma la sostanza parla chiaro: Borderlands 2, Max Payne 3 (si spera anche GTA V), Crysis 3, Mists of Pandaria e Unreal Engine 4 sono nomi molto importanti che senza dubbio pongono Nvidia in vantaggio per quanto riguarda l'ottimizzazione dei titoli per l'hardware proprietario. Potete dare un'occhiata ai benchmark rilasciati da Nvidia stessa nella tabella qui a fianco: sono stati presi a 1080p in DirectX 11, ma altri dettagli non sono noti, quindi non possiamo a maggior ragione tirare le somme. Tuttavia se siete possessori di 560 Ti o 570 e cercavate un buon aumento della conta degli FPS, il nostro consiglio è di gettarvi sulla succulenta ma carissima 680 per riscontrare un incremento sensibile o altrimenti aspettare ancora qualche tempo. Quel che è certo in ogni caso è che con prezzi simili e consumi così ridotti, i vostri soldi saranno ben spesi comunque vada l'acerrima battaglia a colpi di FPS, Riva Tuner e 3D Marks, che mai come oggi avrà un esito tutt'altro che scontato.