Immutate nel concetto da quattro decadi, le CPU sono i cervelli elettronici, sempre più piccoli, che permettono a PC, console e dispositivi mobile di sfruttare tutte le componenti secondarie per sfornare servizi, applicazioni e tutta la magia del mondo multimediale moderno. Una reale innovazione manca da tempo insomma, ma d'altronde quando l'oggetto che hai per le mani è virtualmente capace di tutto, almeno in senso informatico, tutto quello che conta è il rapporto tra dimensioni, prezzo e potenza. Un'evoluzione reale è ovviamente possibile e la scienza la sta inseguendo a spron battuto progettando nuovi transistor potenzialmente rivoluzionari. Ma anche se Intel ha già proposto qualche novità effettiva con i transistor a tre gate si tratta di un'evoluzione relativa, ancora sfruttata timidamente. Per il resto spaziamo ancora nella scienza futuristica progettando computer quantici, mescolando silicio con tessuti nervosi e sviluppando transistor della dimensione di un atomo capaci di mantenere la memoria. Tutte tecnologie interessanti ma le cui funzionalità effettive sono ancora perse nel marasma della teoria. Ma anche se l'obiettivo ultimo è, ovviamente, il temibile computer pensante è molto probabile che, dovendo far girare programmi sviluppati dall'uomo, persino la più evoluta delle macchine immaginabili avrà probabilmente alla base una logica comprensibile da un essere umano. D'altronde anche introducendo la casualità ci saranno circuiti da chiudere e aprire, ci sarà un meccanismo di input e output, le due fasi che contraddistinguono anche la società umana che pur ammettendo il forse e l'astrazione, è regolata da sì e no, da veri e falsi, da assoluti che permettano l'applicazione delle norme, delle leggi e della regolamentazione. Ma evitiamo, state tranquilli, di addentrarci nel mondo della giurisprudenza per tornare invece indietro, alle radici della storia delle CPU classiche che ha cambiato proprio il corso proprio con l'adozione della logica binaria.

Un tuffo nella genesi delle CPU con il primo speciale di una serie dedicata alla storia del PC

Dinosauri da fantascienza

Contrariamente a quanto molti possano pensare, la CPU non è nata con il computer. Quest'ultimo è una creazione precedente, intesa come grossa unità logica capace di portare a termine uno specifico compito di calcolo. Ma privi di una CPU capace di reindirizzare a piacimento le funzionalità di un calcolatore, i primi computer richiedevano un cambio fisico della struttura delle connessioni per essere destinati a utilizzi differenti da quello iniziale, mentre con l'avvento degli stored-program computer, ovvero calcolatori capaci di "leggere" i programmi, tutto è cambiato. Ci troviamo nel 1949 e stiamo parlando dell'EDVAC (Electronic Discrete Variable Automatic Computer), un dispositivo che ha segnato anche il passaggio dal pensiero elettronico decimale al linguaggio binario usato appunto per scrivere e decifrare i programmi. La logica di fondo del PC non è cambiata da quel giorno anche se si sono aggiunte unità di input, sistemi di controllo e via dicendo, mentre quello che è cambiato radicalmente è la dimensione. L'EDVAC era un mostro da 45.5 metri quadrati, caricato con 12 mila diodi e dal peso di quasi otto tonnellate. Inoltre per farlo funzionare servivano trenta persone e le operazioni di calcolo includevano un margine di errore, al contrario dei computer a relay che erano più lenti ma più affidabili. Entrambe le tecnologie, comunque, sono finite in pensione senza possibilità di appello, cessando di avere un senso con l'avvento dei transistor: le unità, sempre più minute, che ancora oggi sono alla base di qualsiasi sistema di calcolo. Ma prima di passare oltre diamo uno sguardo anche ai calcolatori decimali, meno versatili rispetto a quelli basati su logica binaria ma comunque fondamentali nell'evoluzione del computer. Pur divenendo operativo dopo l'EDVAC, già basato sulla logica binaria e capace di caricare programmi a piacimento, uno dei calcolatori elettronici più celebri dell'era decimale è stato il WITCH (Wolverhampton Instrument for Teaching Computing from Harwell), una macchina capace di immagazzinare 20 sequenze da 8 cifre che sono state poi espanse a 40. Le possibilità di calcolo che derivano da una sequenza di numeri così limitata sono oggi irrisorie, questo è chiaro, ma all'epoca, ovvero nel 1951, capacità del genere erano quasi fantascienza poiché il computer era visto, anche all'interno dell'ambito scientifico, come un prodigio dalle potenzialità sconosciute. Ma quello che ha reso il WITCH speciale non è stata la sua nota affidabilità, tale da consentirne la ristrutturazione e la messa in funzione presso il National Museum of Computing, e non sono state neppure le sue dimensioni, 6x2x1 metri, decisamente minute se confrontate con quelle di calcolatori più avanzati ma mastodontici come EDVAC. Quello che ha reso il WITCH magico, tanto da influenzare l'immaginario fantascientifico dell'epoca, è stato l'impiego dei Dekatron, valvole termoioniche riempite di gas e capaci di mostrare visivamente la conta degli impulsi sfruttati dalla macchina per immagazzinare cifre e utilizzarle per operazioni di calcolo. Il risultato è un calcolatore alla Wargames, con lucine semoventi e roteanti capaci di suggestionare ancora oggi, in un'epoca in cui computer migliaia di volte più potenti del WITCH stanno comodamente in un taschino. Non è un caso che ancora oggi questa tecnologia sia ancora utilizzata sebbene lo sia solo dal punto di vista "hobbystico" mentre sul versante pratico il leggendario calcolatore, limitato nella versione con Dekatron a idrogeno a un massimo di 1GHz di frequenza, è stato condannato all'oblio dalla diffusione e dal rimpicciolimento dei computer a logica binaria.

La prima vera CPU

Prima di arrivare a quella che è considerata la prima vera CPU dobbiamo passare dalla sostanza che costituisce i chip, il già menzionato transistor, un semiconduttore utilizzabile per amplificare e indirizzare segnali elettronici il cui primo prototipo è nato nel 1925 per mano del fisico canadese Julius Edgar Lilienfeld. Poi, nel 1934, il tedesco Oskar Heil ha brevettato un dispositivo simile e la prima versione moderna del transistor, anche se all'epoca veniva usato il germanio al posto del silicio, è venuta al mondo nei laboratori Bell ad opera di Walter Brattain e John Bardeen che, nel 1956, si sono aggiudicati, a ragion veduta, un meritato Premio Nobel. Il mondo ancora non lo sapeva, perso tra boom economici e Guerra Fredda, ma era nato il primo semiconduttore utilizzabile in campo informatico e verso la fine degli anni 50, con la costruzione dei primi transistor al silicio, era iniziata l'era della miniaturizzazione.

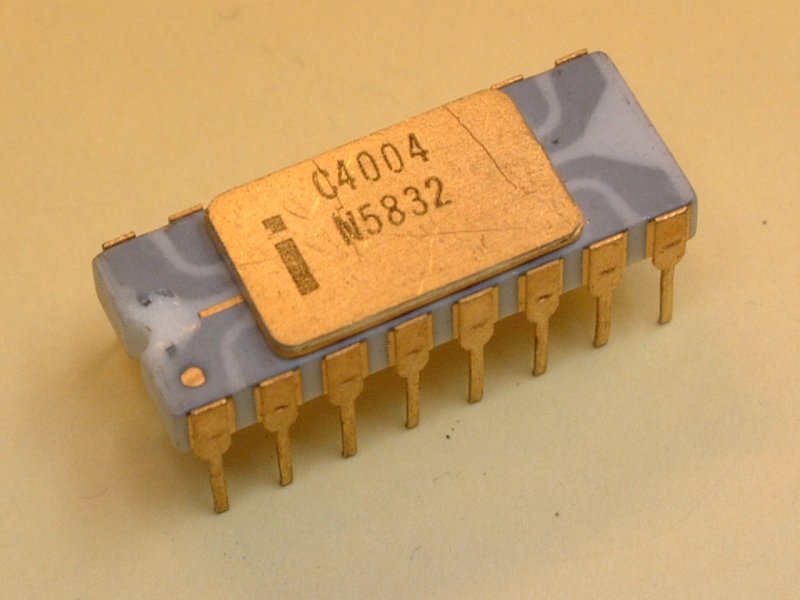

Parallelamente sono stati sperimentati diversi tipi di transistor, anche in vetro e in ceramica, ma il silicio si è dimostrato il più duttile e versatile e non è un caso che sia utilizzato ancora oggi. Nonostante i festeggiamenti e l'evidenza di una svolta epocale sono ovviamente serviti diversi anni per arrivare alla prima vera CPU, ruolo che è toccato a un chip "multipurpose" nato da un progetto orientato alla costruzione di calcolatrici da tavolo. L'architettura di queste calcolatrici venne messa su carta dagli ingegneri della società giapponese Busicom che nel 1969 si rivolse all'allora neonata Intel per passare dalla teoria alla realizzazione effettiva del prototipo. Ma quando Ted Hoff, capo del dipartimento di ricerca di Intel, si trovò di fronte all'architettura nipponica composta da sette chip, notò che poteva essere semplificata e ridotta a quattro chip. Lo fece senza troppi problemi e convinti i giapponesi, Hoff esaurì il suo compito lasciando il progetto che però, invece di partire, rimase parcheggiato per diversi mesi. E questo ritardo rappresentò un'occasione d'oro per Federico Faggin, fisico e informatico italiano che si trovò a ricoprire il ruolo di chip designer di Intel nell'aprile del 1970. A quanto pare Faggin, pur arrivato di fresco, aveva già le idee molto chiare e iniziò a lavorare a tutto spiano avvalendosi dell'aiuto dell'ingegnere giapponese Shima, incaricato da Busicom di seguire lo sviluppo di un progetto che era già in estremo ritardo. Ebbene, il dinamico duo stupì tutti e in soli 9 mesi portò a termine un progetto radicalmente trasformato, con un risultato talmente innovativo da poter essere indicato come la prima vera CPU miniaturizzata. Non si trattava di quattro chip, come previsto dal progetto di Hoff, ma di uno solo che, tra l'altro, incorporava la gestione dei bus di memoria e di I/O, compiti anche successivamente deputati a controller specifici e non alla CPU, rappresentando il non plus ultra della tecnologia informatica. Il 4004, 4 bit e 2.300 transistor contro i miliardi che attualmente compongono CPU e GPU, venne completato nel marzo del 1971 e rese quel mese speciale per l'informatica anche se all'epoca pochi si rendevano conto delle implicazioni. Gli stessi manager di Intel, fino a quel momento impegnata solo nella produzione di memorie, non avevano alcuna idea di dove sarebbe arrivata la loro compagnia proprio grazie a quel singolo chip commissionato da una ditta di calcolatrici giapponese e rivoluzionato da un italiano.

Non solo x86

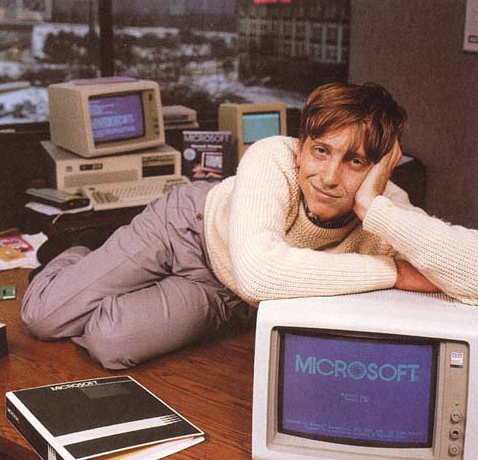

La strada per arrivare al primo computer casalingo era ancora molto lunga ma l'Intel 4004, con il suo set di 46 istruzioni e la sua limitata capacità di gestire un massimo di 640 Byte di memoria, era il primo mattone di un muro che si sarebbe presto popolato di microprocessori, istruzioni standardizzate, istruzioni aggiuntive, GPU, SoC, APU, socket, assemblati e prototipi in graphene, il materiale scoperto per caso che molti ritengono essere il trampolino di lancio per una rivoluzione informatica. Di tutte queste cose parleremo nella seconda parte di questa nuova rubrica che chiudiamo parlando dell'altro grande passo nel campo delle CPU. Ci riferiamo all'Intel 8086, progettato nel 1978, che è stato il primo processore a impiegare il set di istruzioni x86. Seppur potenziata e arricchita da istruzioni aggiuntive, l'architettura X86, all'epoca a 16 bit, è ancora la più utilizzata e ha dato vita all'era dei programmi compatibili. L'evoluzione dell'8086, ovvero l'8088, è stata impiegata nel 5150, il PC della IBM che, equipaggiato con l'MS-DOS di Bill Gates, ha dato il via alla diffusione di massa dei Personal Computer.

Un evento di radicale importanza anche se dobbiamo specificare che tutto questo non sarebbe accaduto, o almeno non lo avrebbe fatto in tempi così brevi, senza la Apple di Steve Jobs, senza la celeberrima Commodore e senza le prime console da gioco. Apple e Commodore diedero il via alle danze adottando, per l'Apple I e il Vic 20, il MOS 6502 di MOS Technology, un processore a 8 bit estremamente economico e incredibilmente veloce, venduto a soli 25 dollari contro i 175 chiesti per un Motorola 6800. E versioni modificate di questa CPU diedero vita ad altre macchine molto celebri tra cui l'Atari 2600, l'Atari 800XL e l'intramontabile Nintendo Entertainment System (NES). Ma non possiamo dimenticarci dello Zilog Z80, altro microprocessore leggendario che ha fatto da cervellone per un incredibile numero di dispositivi. Tra questi spiccano indubbiamente il Commodore 128, il ColecoVision e lo Sinclair ZX Spectrum, il primo Game Boy, il SEGA Master System e il Neo Geo AES, versione casalinga del leggendario hardware da coin op. Un successo titanico, ottenuto non solo grazie all'ottima qualità del prodotto, che vanta la firma del summenzionato Federico Faggin, ma anche grazie alla politica di Zilog che ha concesso la licenza di sfruttamento del core della CPU, senza chiedere royalties, a qualunque società interessata. Una combinazione che ha portato lo Z80 a essere usato in sintetizzatori MIDI, come processore per schede sonore (usato in questo modo anche per il MegaDrive), chip per decoder, unità logica per fax, chip per il riconoscimento vocale, CPU per mixer video, controller per schede SCSI per PC, cervellone per FAX, modem e commutatori telefonici. Un successo planetario che ha permesso a Zilog di arrivare fino a oggi con l'eZ80, successore dello Z80 e usato per alcuni dei dispositivi che abbiamo già menzionato, per controller ad uso industriale e per i chipset di svariati hard disk tra cui alcuni modelli targati Seagate. Risultati davvero niente male per chip che potevano gestire pochi kb di RAM e raramente raggiungevano i 10 MHz, ma in ambito gaming, nonostante le premesse favorevoli alla concorrenza è stata Intel a vederci lungo. Oggi, dopo tanti anni di chip dedicati, con la sola eccezione della prima Xbox, le console sono tornate alle istruzioni x86 la cui evoluzione, chip per chip, sarà uno degli argomenti della prossima puntata.