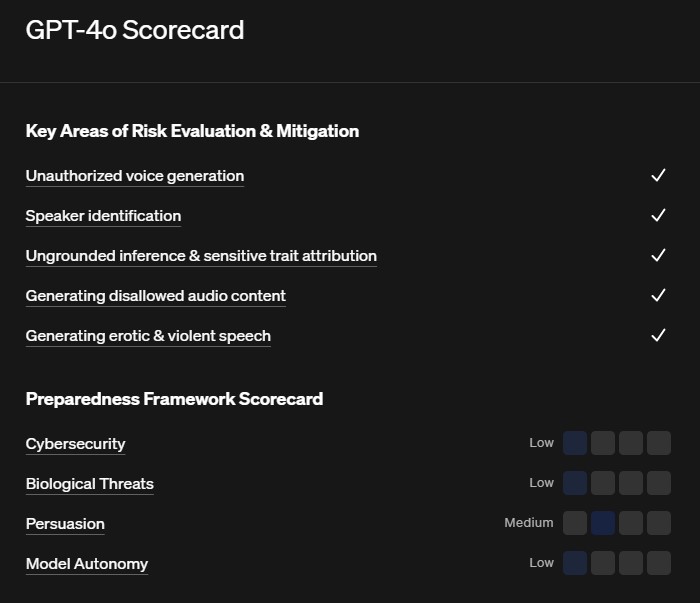

OpenAI ha reso pubblica la "GPT-4o System Card", un documento di ricerca che illustra le misure di sicurezza e le valutazioni dei rischi condotte prima del lancio del suo ultimo modello di intelligenza artificiale. E secondo la valutazione di OpenAI, GPT-4o presenta un "rischio medio". Questa classificazione deriva dalla valutazione più alta tra quattro categorie di rischio: sicurezza informatica, minacce biologiche, persuasione e autonomia del modello.

Tutte le categorie sono state considerate a basso rischio, tranne la persuasione, dove alcuni campioni di scrittura di GPT-4o si sono dimostrati più efficaci nel convincere i lettori rispetto a testi scritti da umani.

La pubblicazione di questa valutazione dei rischi avviene in un momento cruciale per OpenAI. L'azienda è stata oggetto di continue critiche riguardo ai suoi standard di sicurezza, sia da parte dei suoi stessi dipendenti che da parte di senatori statunitensi. Il lancio di un modello multimodale così potente, in prossimità delle elezioni presidenziali statunitensi, solleva infatti preoccupazioni sul potenziale rischio di diffusione accidentale di disinformazione o di utilizzo malevolo da parte di attori malintenzionati. OpenAI spera di dimostrare il suo impegno nella prevenzione degli abusi attraverso la pubblicazione di questi test.

Sono state sollevate numerose richieste affinché OpenAI sia più trasparente, non solo sui dati di addestramento dei suoi modelli, ma anche sui test di sicurezza. In California, dove ha sede OpenAI, il senatore Scott Wiener sta lavorando a un disegno di legge per regolamentare i modelli linguistici di grandi dimensioni, introducendo restrizioni che renderebbero le aziende legalmente responsabili in caso di utilizzo dannoso della loro IA.

La pubblicazione della GPT-4o System Card è insomma un passaggio volto a mostrare l'impegno di OpenAI verso la trasparenza, ma solleva anche interrogativi sulla capacità dell'azienda di valutare obiettivamente i rischi dei propri modelli. La crescente pressione per una maggiore regolamentazione dell'IA potrebbe portare a cambiamenti significativi nel modo in cui le aziende come OpenAI sviluppano e rilasciano i loro modelli.

Voi che cosa ne pensate? Serve una maggiore attenzione sulle cosiddette intelligenze artificiali? Diteci la vostra nei commenti qua sotto.