Qualcomm ha ufficialmente alzato l'asticella nel mercato dei laptop con il lancio dei nuovi chipset a 3 nanometri, ma è il modello di punta, lo Snapdragon X2 Elite Extreme, a catturare l'attenzione degli esperti per una scelta tecnica senza precedenti.

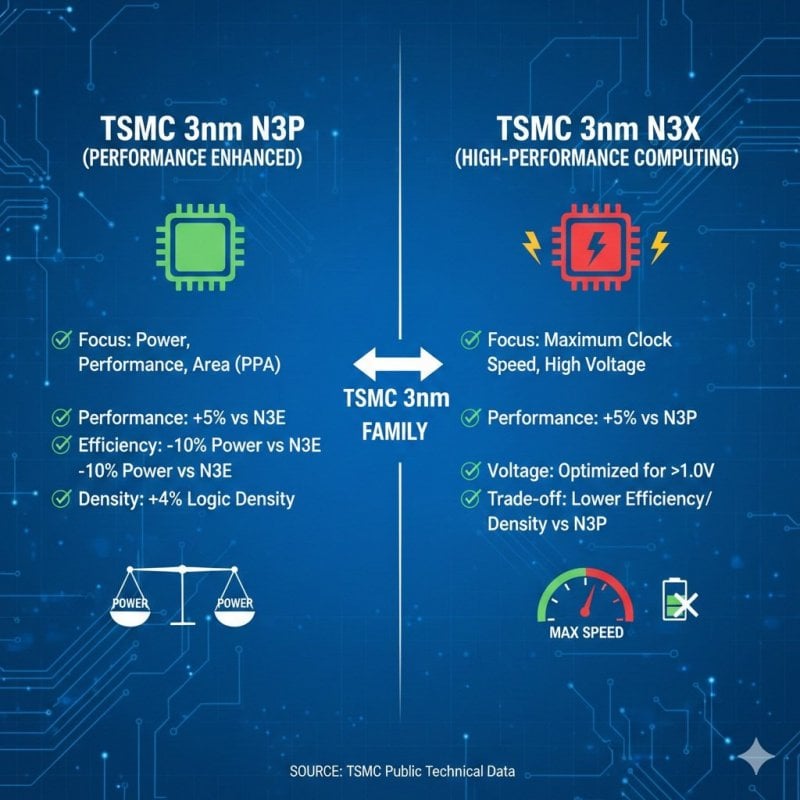

Secondo un recente report di Moor Insights & Strategy, questo SoC a 18 core non utilizza i processi produttivi standard di TSMC (come l'N3E o l'N3P), bensì il nodo 3nm N3X, una litografia estrema progettata specificamente per massimizzare le frequenze di clock e le prestazioni di calcolo. L'uso del processo N3X permette allo Snapdragon X2 Elite Extreme di raggiungere una frequenza impressionante di 5,00 GHz su uno o due core.

I motivi della scelta di Qualcomm e la soluzione proposta per lo Snapdragon X2 Elite Extreme

Si tratta di una soluzione orientata all'High-Performance Computing (HPC), che consente al chip di operare a tensioni superiori a 1.0V. Tuttavia, questa spinta verso la potenza bruta comporta dei compromessi inevitabili: rispetto al nodo N3P, il processo N3X offre una densità di transistor inferiore e, soprattutto, una minore efficienza energetica.

Il processore può infatti superare la soglia dei 100W di consumo quando non è vincolato da limiti termici, mantenendo circa 40W in carichi sostenuti all'interno degli chassis dei laptop. Un'altra caratteristica distintiva è l'architettura System-in-Package (SiP). Similmente a quanto fatto da Apple con i suoi chip della serie M, Qualcomm ha integrato la memoria RAM direttamente nel pacchetto per abbattere le latenze e aumentare la larghezza di banda.

I benchmark dello Snapdragon X2 Elite Extreme

Nonostante l'impiego di 31 miliardi di transistor e tecnologie all'avanguardia, i primi benchmark mostrano un quadro agrodolce. In Cinebench 2024, lo Snapdragon X2 Elite Extreme risulta ancora più lento dell'Apple M4 Max sia in single-core che in multi-core.

Anche sul fronte grafico la sfida è complessa: la GPU integrata di Qualcomm viene superata dall'M4 Pro, che si dimostra fino al 45% più veloce in test sintetici come 3DMark. Resta da vedere se l'ottimizzazione software futura saprà sfruttare appieno il potenziale di questo ambizioso hardware.