Un nuovo studio condotto dal Tow Center for Digital Journalism ha gettato nuova luce su un problema già noto, ma che sembra persistere nonostante i progressi tecnologici: l'inaffidabilità dei chatbot basati sull'intelligenza artificiale generativa. La ricerca, pubblicata sulla Columbia Journalism Review, ha analizzato le risposte di diversi motori di ricerca AI a 200 query basate su articoli giornalistici, rivelando una tendenza allarmante a fornire informazioni errate con estrema sicurezza.

Lo studio ha cercato di capire quanto i chatbot siano in grado di fornire risposte accurate a domande di carattere giornalistico. Si è partiti da un dato di fatto: l'intelligenza artificiale è sempre più presente nella nostra vita quotidiana e viene utilizzata per ottenere informazioni su qualsiasi argomento. Ma quanto ci si può fidare delle risposte fornite da questi strumenti?

I risultati dello studio

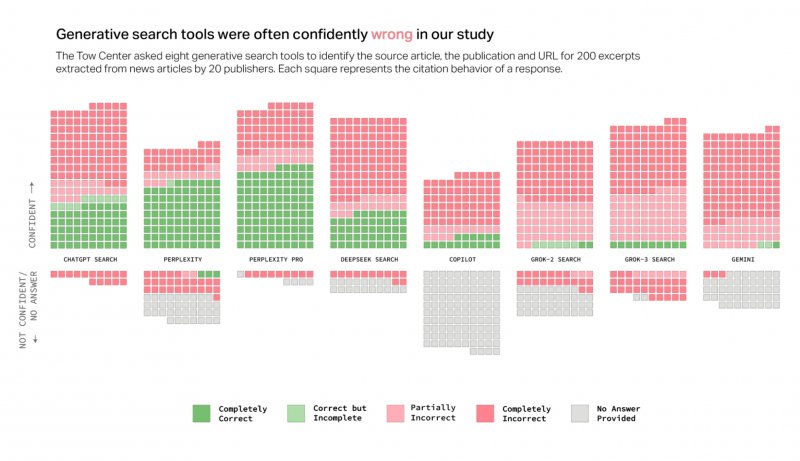

I risultati della ricerca sono stati preoccupanti. ChatGPT Search, ad esempio, è risultato l'unico strumento AI a rispondere a tutte le 200 domande, ma solo il 28% delle risposte era completamente accurato, mentre ben il 57% conteneva informazioni totalmente errate. Questo dato conferma quanto già osservato in precedenza, ovvero la tendenza di ChatGPT a rispondere con sicurezza anche a domande su cui non ha informazioni certe.

Ma ChatGPT Search non è il solo a mostrare delle lacune. Entrambe le versioni di Grok AI di X hanno mostrato prestazioni scadenti, con Grok-3 che ha raggiunto un impressionante 94% di risposte inaccurate. Anche Microsoft Copilot non ha brillato, rifiutandosi di rispondere a 104 query su 200 e fornendo un tasso di inaccuratezza del 70% circa nelle risposte fornite.

Ciò che rende la situazione ancora più paradossale è la mancanza di trasparenza delle aziende produttrici riguardo questa inaffidabilità. Curiosamente, poi, le versioni a pagamento come Perplexity Pro e Grok-3 Search sembrano anche meno affidabili: "si potrebbe presumere che i modelli premium, come Perplexity Pro (20 dollari al mese) o Grok 3 (40 dollari al mese), siano più affidabili delle loro controparti gratuite", si spiega nello studio, "dato il loro costo più elevato e i presunti vantaggi computazionali. Tuttavia, i nostri test hanno dimostrato che, sebbene entrambi abbiano risposto correttamente a più richieste rispetto ai loro equivalenti gratuiti, hanno paradossalmente dimostrato anche tassi di errore più elevati".

Questa contraddizione, secondo gli autori, deriverebbe dalla loro tendenza a fornire risposte definitive, ma errate, piuttosto che rifiutarsi di rispondere direttamente alla domanda.

E voi, cosa ne pensate? Avete avuto esperienze simili con i chatbot? Condividete le vostre opinioni nei commenti. Intanto anche l'azienda che assembla iPhone ha sviluppato una sua IA: arriva FoxBrain di Foxconn.