Intel ha presentato ufficialmente uno strumento basato sull'intelligenza artificiale in grado di valutare la grafica dei videogiochi. Si tratta del CGVQM, ovvero Computer Graphics Visual Quality Metric, ed è disponibile su GitHub come applicazione PyTorch. Vediamo di seguito tutti i dettagli in merito.

Come funziona il CGVQM

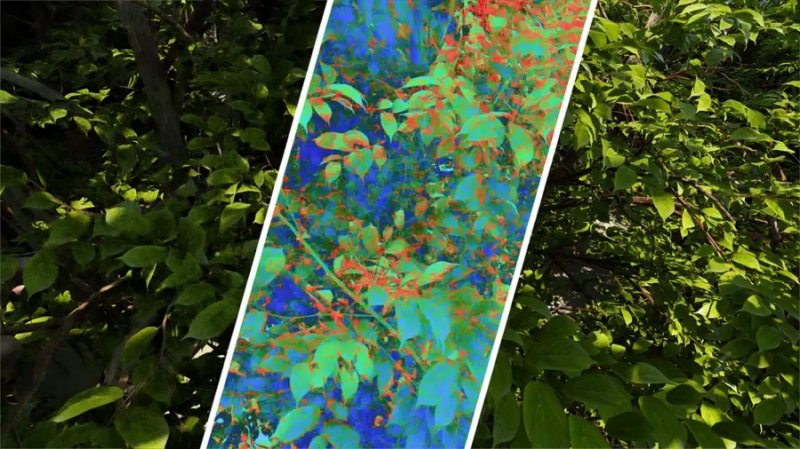

Si tratta di uno strumento open source in grado di analizzare in tempo reale i contenuti grafici prodotti da tecnologie come patch tracing, XeSS, FSR, DLSS e altre. Questa novità è stata introdotta per offrire risultati migliori di PSNR o SSIM, che valutano la compressione video ma non sono in grado di evidenziare eventuali artefatti, problematiche di ghosting o instabilità nel dettaglio. Le metriche classiche, infatti, non riescono a rilevare contenuti dinamici come quelli dei videogiochi.

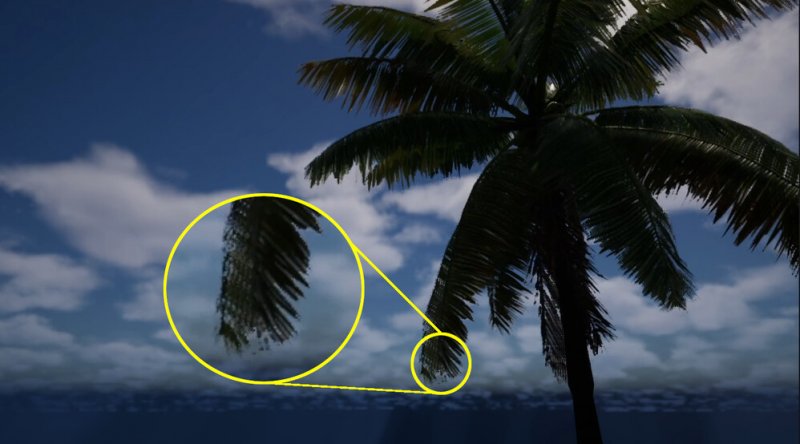

In questo caso, lo strumento di Intel si basa su CGVQM, quindi il modello IA principale, e CGVQD, un dataset da 80 clip video tratte da 15 ambienti 3D. Tra queste troviamo ad esempio ambientazioni come House e Bridge, oppure la demo Bistro di Amazon. I video vengono suddivisi in piccoli blocchi e, tramite la rete neurale, vengono estratte delle caratteristiche visive, regolando poi i pesi dei canali per generare uno score di qualità coerente con la percezione umana.

Il modello è a sua volta diviso in due parti. CGVQM-5 analizza tutti e cinque i blocchi della rete ResNet e offre risultati più accurati. CGVQM-2 utilizza invece i primi due blocchi e offre risultati più leggeri e veloci.

Uno strumento per identificare il degrado qualitativo

Questo nuovo strumento di Intel è volto a rilevare le zone più colpite da artefatti, quindi i punti specifici in cui si presenta un degrado qualitativo, facilitandone la correzione. Offre inoltre supporto al plugin di Unreal Engine e hook per API Vulkan, quindi gli sviluppatori possono integrarlo direttamente nei flussi di sviluppo.

Inoltre, questa metrica consente di determinare automaticamente il numero minimo di sample-per-pixel necessari per produrre contenuti percettivamente uguali al ground truth. Ciò significa maggiore ottimizzazione e minor tempo di rendering. In calce trovate la fonte ufficiale con ulteriori informazioni in merito e video dimostrativi.