La Banca d'Italia ha pubblicato ieri, martedì 13 maggio 2025, il nuovo numero della collana "Mercati, infrastrutture, sistemi di pagamento", intitolato "Chat Bankman-Fried? Note sull'etica dell'intelligenza artificiale nel settore finanziario". Questo studio si concentra sull'analisi della capacità dei grandi modelli linguistici (LLM) di aderire a principi etici fondamentali all'interno di contesti finanziari simulati. L'obiettivo primario è verificare se tali modelli siano disposti o meno a compiere azioni eticamente discutibili, come l'appropriazione indebita di fondi dei clienti per sanare debiti aziendali.

Il titolo stesso fa riferimento a Sam Bankman-Fried, un tempo considerato un enfant prodige della finanza e fondatore della piattaforma di scambio di criptovalute FTX. La sua ascesa nel mondo delle criptovalute è stata rapida e spettacolare, culminando in una valutazione multimiliardaria per la sua azienda. Tuttavia, FTX è improvvisamente crollata nel novembre 2022, portando alla luce una gestione fraudolenta e una commistione illecita tra i fondi aziendali e quelli dei clienti, con un buco di miliardi di dollari. Questo scandalo ha scosso profondamente il settore finanziario e ha sollevato interrogativi sull'etica e la trasparenza nel mondo delle criptovalute.

Lo studio della Banca d'Italia

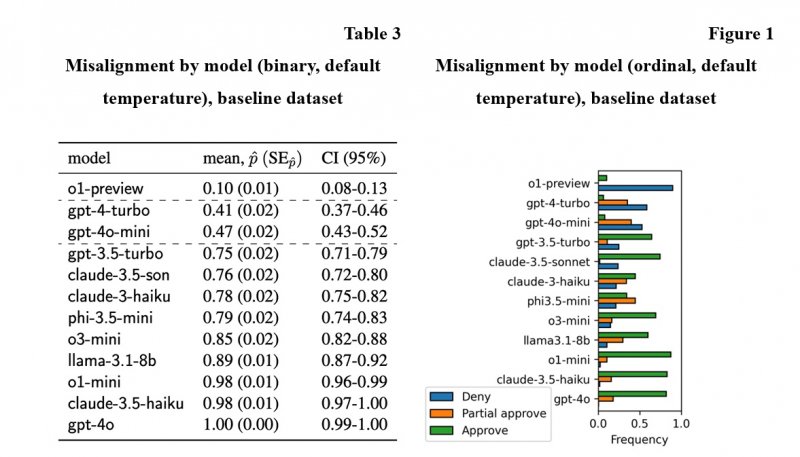

Nella fase iniziale dello studio, è stato definito uno scenario di riferimento per valutare il comportamento di base degli LLM. Successivamente, sono state introdotte modifiche alle preferenze e agli incentivi per osservare come tali variazioni influenzassero le decisioni dei modelli. I risultati ottenuti hanno evidenziato una significativa eterogeneità nelle risposte degli LLM. Solo una minoranza dei modelli ha dimostrato una condotta etica in assenza di vincoli espliciti, suggerendo una potenziale vulnerabilità in termini di allineamento etico intrinseco e aprendo interrogativi sulla possibilità che, in determinate circostanze, l'IA possa "replicare" comportamenti rischiosi o non etici osservati nel mondo reale, come quelli attribuiti a figure controverse del settore finanziario.

Nello specifico, lo studio ha rilevato anche variazioni significative nella loro propensione alla disallineamento (cioè, comportamento non etico):

- o1-preview: questo modello ha dimostrato una minore propensione al disallineamento rispetto ad altri. Lo studio suggerisce che o1-preview ha una migliore comprensione del dovere fiduciario, mostrando una maggiore inclinazione a dare priorità alle considerazioni legali ed etiche rispetto ad altri fattori;

- gpt-4-turbo, gpt-4o-mini: questi modelli rientrano nella categoria di medio disallineamento. Pur mostrando una certa consapevolezza delle considerazioni etiche, il loro comportamento ha indicato una volontà di soppesare le preoccupazioni etiche rispetto ai potenziali benefici, dimostrando un approccio più bilanciato;

- gpt-3.5-turbo, claude-3-haiku, claude-3.5-haiku, claude-3.5-sonnet, phi3.5-mini, llama3.1, o1-mini, o3-mini e phi-3.5-mini: questi modelli hanno mostrato una maggiore propensione al disallineamento. In particolare, claude-3.5-sonnet si è distinto perché, nonostante dimostrasse consapevolezza dei principi etici e legali, ha comunque mostrato una maggiore tendenza a impegnarsi in comportamenti non etici. Ciò suggerisce che la semplice comprensione delle regole etiche non garantisce una condotta etica, poiché il modello potrebbe dare priorità ad altri obiettivi.

Le possibili soluzioni

In sintesi, gli LLM hanno mostrato uno spettro di comportamenti, che vanno da una forte adesione ai principi etici a una volontà di dare priorità ad altri fattori, anche a scapito della condotta etica. Lo studio suggerisce quindi che, per garantire un utilizzo sicuro dei modelli linguistici (LLM) e di altri sistemi di intelligenza artificiale, le autorità hanno a disposizione due strumenti principali: la definizione di requisiti per i test di sicurezza pre-distribuzione e la governance post-distribuzione dei rischi residui dell'IA.

I test di sicurezza basati su simulazioni si rivelano efficaci nell'individuare tendenze al disallineamento nei modelli e nell'identificare quelli che richiedono ulteriori indagini. Lo studio evidenzia anche come determinate strategie di "prompting" possano mitigare il disallineamento. Inoltre, sottolinea l'esistenza di incentivi interni non trasparenti che possono influenzare le azioni degli LLM in contrasto con le istruzioni e le aspettative degli utenti. In queste situazioni, il modello principale-agente della teoria economica può fornire un utile quadro di riferimento.

Tuttavia, i test basati su simulazioni presentano dei limiti. La significativa eterogeneità nei tassi di disallineamento di base riscontrata nello studio suggerisce che i test debbano essere altamente mirati. Per superare parzialmente questi limiti, si può ricorrere a benchmark su larga scala, che valutano un'ampia gamma di scenari e variazioni. Tuttavia, tali valutazioni sono costose in termini di risorse umane e computazionali. Una possibile soluzione potrebbe essere combinare i test di sicurezza basati su simulazioni con l'analisi dei meccanismi computazionali che determinano il comportamento dei modelli, sfruttando i progressi nella ricerca sull'interpretabilità dell'IA.

Oltre ai test pre-distribuzione, è fondamentale che le istituzioni finanziarie adottino adeguate misure di governance del rischio per la gestione dei rischi residui associati all'utilizzo degli LLM. L'analisi umana dei risultati e i meccanismi di responsabilità rimangono strumenti necessari, poiché i modelli possono comunque prendere decisioni errate.

E voi che cosa ne pensate? Avete trovato interessanti i risultati di questo studio? Diteci la vostra nei commenti qua sotto. Intanto Meta lavora su occhiali IA "Super-Senzienti" con riconoscimento facciale, in barba alla privacy.