Microsoft ha annunciato l'arrivo di un nuovo modello nella famiglia Phi: si tratta di Phi-4-mini-flash-reasoning, progettato per operare in contesti dove potenza di calcolo, memoria e latenza sono fattori critici. Il modello è pensato per essere integrato in applicazioni mobili, dispositivi edge (come smartphone e tablet, sensori IoT, telecamere di sorveglianza intelligenti, wearable, ecc) e altri scenari dove l'efficienza operativa è prioritaria. Può, insomma, eseguire complessi processi IA direttamente su smartphone e dispositivi personali, senza accedere al cloud.

Derivato dal precedente Phi-4-mini, questo nuovo modello introduce una diversa architettura interna, che consente di aumentare significativamente la velocità di esecuzione delle operazioni, mantenendo intatta la capacità di ragionamento logico e matematico. È già disponibile tramite Azure AI Foundry, il catalogo API di NVIDIA e la piattaforma Hugging Face.

Le capacità di Phi 4

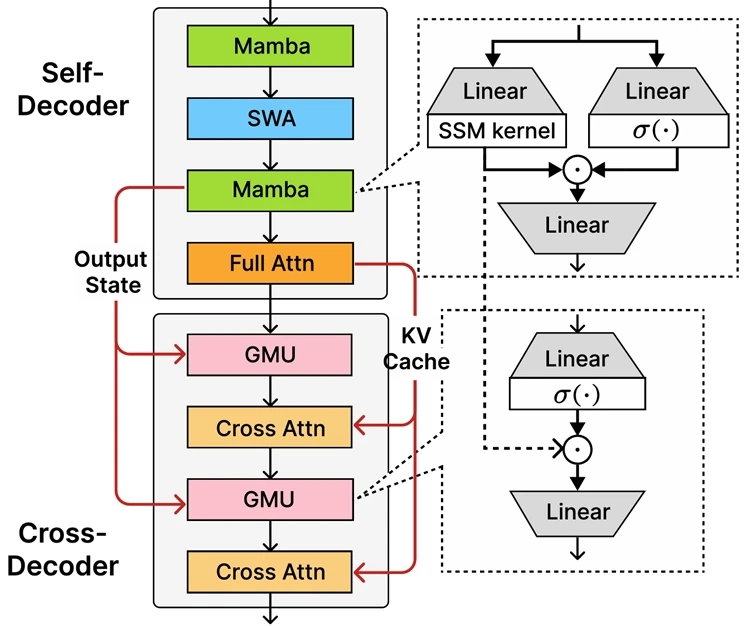

Phi-4-mini-flash-reasoning mantiene la stessa dimensione parametrica del suo predecessore, pari a 3,8 miliardi di parametri, ma sfrutta una nuova architettura denominata SambaY. Al centro di questa struttura si trova un'innovazione chiamata Gated Memory Unit (GMU), una soluzione che migliora lo scambio di informazioni tra i livelli della rete neurale, con l'obiettivo di ridurre i tempi di inferenza e migliorare la gestione di contesti lunghi.

L'architettura prevede una combinazione tra modelli a stato (Mamba), meccanismi di attenzione a finestra scorrevole e un singolo strato di attenzione completa. A questo si aggiunge un secondo decoder che alterna livelli di attenzione incrociata e GMU, per bilanciare prestazioni e consumo di risorse. Il risultato è un aumento fino a dieci volte del throughput e una riduzione media della latenza tra il 200% e il 300% rispetto ai modelli precedenti.

Il modello supporta una lunghezza di contesto fino a 64.000 token ed è stato addestrato su dati sintetici di alta qualità, con l'obiettivo di garantire prestazioni affidabili in attività che richiedono inferenze logiche complesse. Grazie alla sua efficienza, può essere eseguito anche su una singola GPU, rendendolo adatto per una vasta gamma di applicazioni, comprese quelle distribuite localmente o su dispositivi leggeri.

Il target di utilizzo include ambiti educativi, dove la capacità di elaborare logica matematica in tempo reale è particolarmente utile. Tra i possibili scenari d'impiego figurano piattaforme di apprendimento adattivo, assistenti virtuali su dispositivi mobili e sistemi di tutoraggio interattivo, capaci di modificare il contenuto in base alle risposte degli utenti. Le sue caratteristiche lo rendono interessante anche per simulazioni leggere e strumenti di valutazione automatica.

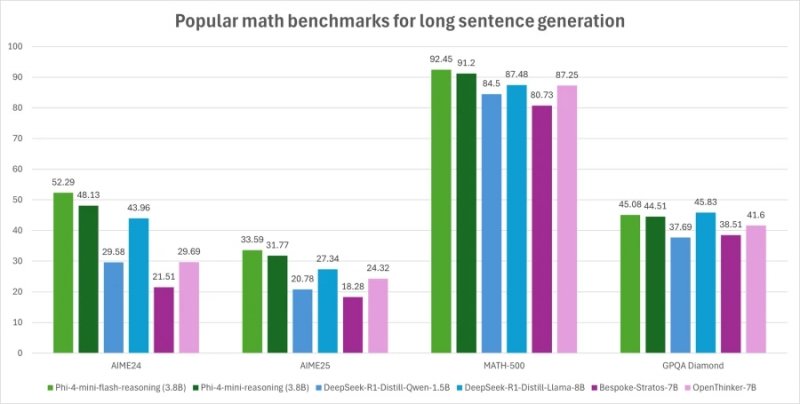

A differenziare ulteriormente Phi-4-mini-flash-reasoning rispetto ad altri modelli simili è la capacità di bilanciare precisione logica e prestazioni in tempo reale, in particolare in situazioni in cui la latenza deve restare bassa e il contesto da elaborare è esteso. Ciò lo rende una scelta rilevante per sviluppatori e aziende alla ricerca di soluzioni AI efficienti e scalabili, anche in assenza di infrastrutture cloud di grandi dimensioni.

Voi che cosa ne pensate? Diteci la vostra nei commenti qua sotto. Intanto Musk presenta Grok 4 e SuperGrok Heavy, l'abbonamento da 300 dollari per l'IA che si paragonava a Hitler.