Nella prima puntata di questa rubrica ci siamo concentrati sui passaggi fondamentali che ci hanno portato dai computer decimali al microprocessore moderno, un concentrato di transistor infinitesimali capace di impacchettare una potenza di calcolo estrema in pochi centimetri. Durante questa fase evolutiva il set di istruzioni che si è imposto è quello legato alla tecnologia x86 ma non è l'unico a caratterizzare le CPU moderne. Nell'ambito mobile, per esempio, si sono imposte diverse architetture, come quelle targate ARM e, parallelamente, diverse altre realtà tecnologiche hanno cercato nuove strade proponendo architetture e set di istruzioni alternative. Una delle tecnologie alternative più celebri è quella RISC, tanto decantata come possibile rivoluzione da essere nominata in pellicole incentrate sul mondo dei computer come Hackers.

Le CPU moderne, la miniaturizzazione, le alternative e il futuro

L'alternativa RISC

L'alternativa RISC nasce nel 1964 sull'onda della necessità di semplificare la struttura delle CPU, spesso contraddistinte da istruzioni quasi mai utilizzate dagli sviluppatori, e ridurne le dimensioni. Il risultato è un prodotto dotato di una capacità di calcolo in virgola mobile molto elevata e questa, non a caso, è la caratteristica principale di molti processori sviluppati secondo questa filosofia. Ma il successo dell'architettura CISC, che caratterizza la diffusissima tecnologia X86, ha impedito alle soluzioni RISC di diffondersi a livello globale sebbene non tutta la ricerca operata in questo campo sia andata perduta. Anzi, l'architettura RISC è stata implementata anche nei processori CISC, a partire dal Pentium Pro, ed è impiegata nella fase dell'elaborazione dei dati in modo da sfruttarne l'elevato potenziale in termini di calcolo in virgola mobile. C'è ovviamente un passaggio intermedio, che prevede la traduzione delle istruzioni CISC in istruzioni RISC, e questo impedisce di sfruttare per intero il potenziale della tecnologia, ma dobbiamo considerare l'importanza di fattori come la compatibilità e la familiarità degli sviluppatori con le istruzioni x86.

Entrambi fattori decisivi che hanno convinto persino Microsoft e Sony a sviluppare una generazione di console, quella appena nata, basata sull'architettura dei PC. In questi anni comunque, diverse CPU RISC hanno avuto i loro momenti di gloria. Stiamo parlando dei processori MIPS usati nelle workstation Silicon Graphic che, in versione ridotta, sono finite in PlayStation, PlayStation 2, PSP e Nintendo 64. Inoltre, c'è una linea di processori RISC che sopravvive ed è quella dei POWER PC che sono stati utilizzati nel caso di Wii, Xbox 360 e PlayStation 3. In campo server infine, l'architettura RISC non è protagonista ma ha, da sempre, un ruolo rilevante ed è utilizzata nel caso dei server Sun Microsystem, in quelli HP e in quelli Dec Alpha. E non finisce qui. Con l'esplosione del settore mobile e la nascita di nuovi ambienti di sviluppo, l'elemento della retrocompatibilità è diventato quasi irrilevante offrendo l'occasione a diversi sistemi operativi nascenti di supportare l'architettura ARM che deriva proprio da quella RISC. Non stupisce dunque, che diversi smartphone utilizzino quest'architettura che ha trovato un ruolo anche nell'ambito dei server compatti, grazie ad AMD, con SoC ARM Cortex A57 Opteron A1100 a 64-bit. Nonostante ciò non è detto che la tecnologia RISC possa tornare a essere una minaccia per le CPU classiche. Come abbiamo già detto, i processori moderni riescono a mescolare il meglio dei due mondi e, inoltre, i chip dedicati come SoC (system on a chip) e APU, innovativi nell'integrazione ma classici nella concezione, riducono lo spazio e aumentano le specializzazioni dei dispositivi senza bisogno di rinunciare alla compatibilità.

Non una CPU grande ma una grande CPU

I sistemi compatti, che includono notebook e tablet, sono i dispositivi che meglio si adattano alla filosofia dei cosiddetti SoC (system on a chip). Parliamo di circuiti che combinano la CPU con altre unità con il risultato di ridurre lo spazio occupato dall'hardware. Ma se il classico SoC si accontenta di combinare memoria, controller e CPU, NVIDIA e AMD hanno già fatto un grosso passo in avanti con le tecnologie Tegra e Fusion. I sistemi sono diversi l'uno dall'altro ma in entrambi i casi l'aggiunta rilevante riguarda l'inclusione di una GPU che rende il sistema integrato capace di effettuare calcoli dedicati alla grafica. GPU che, nelle ultime incarnazioni delle due tecnologie, sono dotate della capacità di effettuare calcoli generici e possono quindi andare in sostegno della CPU espletando funzioni che non hanno a che fare con il calcolo grafico. Nel caso di Tegra, il SoC targato Nvidia, il grosso degli investimenti è finito nell'ambito del mobile, con tablet e console Android studiate appositamente per giocare, mentre l'ambito dei portatili classici è stato trattato marginalmente. Non mancano, in commercio, laptop dotati della tecnologia SoC targata NVIDIA, ma nell'ambito dei portatili è stata AMD, grazie all'ottimo rapporto tra qualità e prezzo a ottenere, almeno inizialmente, gli introiti maggiori.

A questo poi, si aggiungono le nuove console, con Microsoft e Sony che hanno scelto proprio le APU AMD per una nuova generazione all'insegna dell'architettura PC. Parliamo di vittorie importanti che hanno permesso alla compagnia di resistere all'assalto combinato di Intel e NVIDIA e, cosa ancora più importante, di reggere piuttosto bene, nonostante ristrutturazioni e licenziamenti, a una grossa crisi. D'altronde, la scelta di puntare sul rapporto qualità/prezzo è stata proprio quella che, negli anni novanta, ha permesso ad AMD di farsi un nome anche nei confronti del grande pubblico diventando un "competitor" affermato nel campo delle CPU. Intel, certo, è sempre rimasta in vetta ma ha dovuto più volte riconoscere l'esistenza dell'avversaria ed è stata costretta ad abbassare i prezzi dei propri processori evidenziando, ancora una volta, che la sana concorrenza è un vantaggio per l'acquirente finale. E questa non manca di certo nel campo delle soluzioni integrate. Intel è stata addirittura pioniera nel campo dei sistemi integrati, inevitabilmente allettanti vista la capacità di adattarsi a dispositivi di forma e funzione diversa. Il primo SoC di Intel, abbandonato prima di vedere la luce, è stato annunciato nel 2001 ed è conosciuto come progetto Timna. Il secondo invece, è sbucato nel 2007, con il nome in codice Tolapai e, non a caso, è venuto alla luce proprio nell'anno in cui gli smartphone, che dei SoC sono l'espressione più compatta, hanno iniziato, grazie all'iPhone, la loro scalata verso la popolarità. E arriviamo infine al terzo tentativo, andato finalmente in porto, con la famiglia di processori Atom che ha riscontrato un discreto successo grazie all'implementazione in molti dei primi ultra-portatili e questo periodo di grazia è durato fino all'arrivo dei corrispettivi, e più prestanti, chip AMD Brazos. Ma, a quel punto, Intel aveva già cambiato strategia scegliendo di ottimizzare la propria linea di processori classici dotandoli anche di capacità di calcolo grafico. AMD, prevedibilmente, ha fatto lo stesso e oggi i principali processori desktop possono essere equipaggiati anche in portatili compatti grazie a circuiti che integrano CPU e GPU.

I microprocessori del futuro

Il mercato tecnologico attuale, è evidente, punta a creare prodotti sempre più compatti, non importa quali siano le necessità dell'utente e il dispositivo in ballo. Ma, per quanto i risultati raggiunti in questi anni siano strepitosi, per arrivare a sistemi miniaturizzati potenti ed economici come quelli installati nei sistemi desktop non è sufficiente sperare nella sempre più estrema miniaturizzazione dei transistor. Quello che serve, per compiere un balzo tale a consentire a chip infinitesimali di gestire software sempre più esosi, è un netto balzo in avanti in termini di architettura. Ma l'evoluzione, in questo senso, manca da tempo e anche laddove questa c'è, appare piuttosto timida. I transistor tri-gate di Intel, per esempio, sfoggiano una migliore conduttività e consentono un migliore controllo sulla corrente elettrica che li attraversa ma il miglioramento dell'efficienza non basta a voltare pagina. Quello che serve è un cambiamento netto e questa necessità è alla base delle numerose ricerche in corso. Ricerche non ancora culminate in prodotti commerciali ma siamo sicuri che quando queste nuove tecnologie risulteranno appetibili per il mercato, vedremo finalmente il tanto atteso cambiamento.

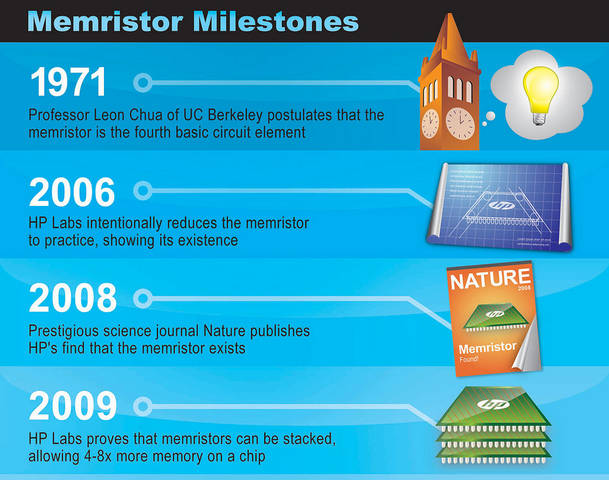

Nel frattempo non ci resta che dare una sbirciata alle tecnologie emergenti che includono l'utilizzo di un nuovo materiale chiamato grafene. Questo, sulla bocca di molti da tempo, non ci ha regalato ancora nulla di tangibile ma il materiale in questione, scoperto per caso, è un ottimo conduttore, è duro come il diamante e ha lo spessore di un solo atomo. Tutti elementi che lo rendono un potenziale candidato alla sostituzione del silicio che è l'elemento che viene utilizzato, ormai da decenni, per la quasi totalità dei transistor che compongono i chip. Ma è nel concept dello stesso come transistor che troviamo l'evoluzione teorica più intrigante. Nel 1971 un teorico dei circuiti chiamato Leon Chua ha immaginato un transistor in grado di ricordare lo stato elettronico e capace, quindi, di formare componenti elettroniche dotate di memoria. Nel caso di un computer, per esempio, memorie e chip ricorderebbero l'intero sistema operativo anche in assenza di corrente e questo eviterebbe perdite di dati consentendo l'avvio istantaneo del PC. E le implicazioni sarebbero ancora maggiori nel caso di CPU formate da atomi impostati per funzionare come i summenzionati transistor che, non a caso, vengono chiamati memristor. In quest'ultimo caso un processore potrebbe essere teoricamente programmato per adattarsi a qualsiasi necessità consentendo di creare hardware custom a partire da componenti inizialmente identiche. Potremmo ottenere chip specializzati da CPU generiche e convertire queste CPU nel caso avessimo necessità diverse da quelle iniziali. Per ora, comunque, dobbiamo accontentarci dei memristor classici, quelli teorizzati da Chua, che presto avranno una prima applicazione pratica sebbene non nel campo delle CPU. La tecnologia rivoluzionaria dovrebbe debuttare nel corso di quest'anno nella forma di nuove memorie chiamate ReRAM. Memorie a basso consumo, grazie alla capacità di ricordare il proprio stato, ma capaci di immagazzinare, grazie alle dimensioni infinitesimali, 100 gigabit in un centimetro quadrato. Tanto per fare un raffronto, nel caso del silicio il limite è di 16 gigabit e stiamo parlando del prototipo creato da HP nell'ormai lontano 2008. La strada verso una CPU costruita con questa tecnologia è lontana ma se le nuove memorie dovessero avere successo come RAM e come memorie a stato solido grazie alla capacità di ricordare, il tragitto verso il futuro dei microprocessori potrebbe accorciarsi notevolmente.