Qualche giorno fa, a San José, in California si è tenuta la sesta conferenza annuale organizzata da NVIDIA sul futuro delle tecnologie grafiche alla quale hanno preso parte più di quattro mila persone provenienti da 50 Paesi. Sul palco si sono alternate le personalità più importanti del colosso di Santa Clara che durante il keynote hanno illustrato le linee guida del percorso intrapreso da NVIDIA mai come ora proiettata verso il futuro e i nuovi impieghi delle sue tecnologie.

I campi di applicazione sono tra i più disparati, dal tradizionale settore videoludico all'affascinante rete neurale passando per quello automobilistico, con una serie di soluzioni molto interessanti che promettono di rivoluzionare il settore promettendo un modo totalmente nuovo di guidare. Insomma, NVIDIA attraverso le parole del suo CEO e co-fondatore Jen-Hsun Huang ha lanciato un segnale forte al suo competitor diretto ma anche a tutto il settore gridando a chiare lettere che non si tratta più solamente di videogiochi, ma che l'esperienza accumulata nel corso di questo ventennio e le tecnologie sviluppate internamente nell'ambito del visual computing possono portare ad applicazioni pratiche impensate qualche anno addietro, aprendo nuovi scenari soprattutto nel campo della ricerca. L'uso delle nuove tecnologie NVIDIA si è diffuso soprattutto nell'ambito della ricerca scientifica in fisica e astronomia, ma anche in medicina, nella navigazione autonoma e soprattutto nell'entertainment dove, come abbiamo visto anche in occasione della Game Developer Conference, il produttore punta ad allargare la sua linea di prodotti dedicati al gaming con la famiglia Shield.

Non solo potenza bruta, ma anche Deep Learning: questo è il futuro secondo NVIDIA

XFactor

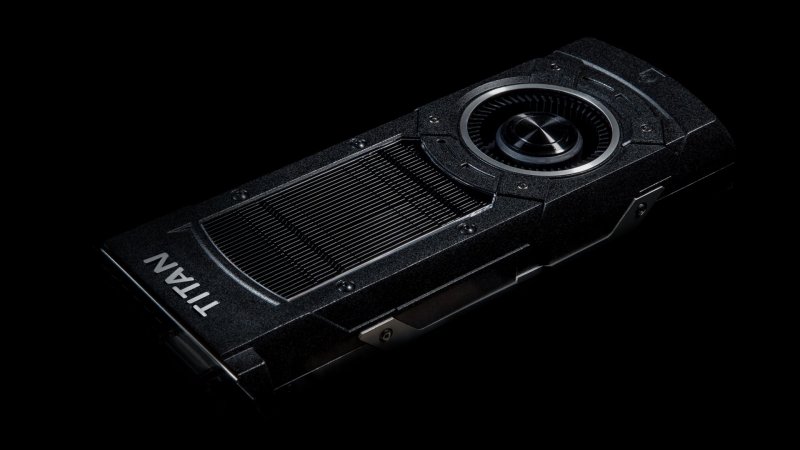

Era nell'aria da un po' di tempo e la GPU Technology Conference è stata l'occasione giusta per presentare al mondo la nuova Titan X, ultimo modello top di gamma di NVIDIA. Come successo con i sui predecessori, questa particolare incarnazione della scheda video spinge al massimo l'architettura Maxwell della serie GTX 9XX realizzando la scheda video più veloce presente sul mercato, che come i suoi predecessori, sarà più un lusso per pochi fortunati che una reale esigenza, soprattutto dal punto di vista videoludico. Come da tradizione, il prezzo sarà la barriera più importante: per portarsi a casa un gioiellino del genere sono necessari 1249€, ma per chi smania di entrare nel mondo del 4K, questa è la via a singola scheda attualmente più indicata.

Per farsi un'idea del suo potenziale in ambito videoludico, basti pensare che una sola Titan X è un grado di processare a 30 fotogrammi al secondo il cortometraggio del bambino con l'aquilone realizzato con l'Unreal Engine 4 mostrato in occasione della Game Developer Conference dei San Francisco qualche settimana fa, senza mostrare rallentamenti o cedimenti di sorta.

Stiamo parlando di una demo ambientata in una valle virtuale dall'ampiezza di ben 100 miglia quadrate in cui i tredici milioni di alberi presenti al suo interno vengono renderizzati in tempo reale, così come l'acqua, i complessi particellari e il profondo sistema di illuminazione dinamico. Un traguardo di assoluto valore che pone la Titan X in cima alla catena alimentare indirizzata a una ristretta nicchia di pubblico, vuoi per il prezzo già citato, vuoi per la possibilità di sfruttarne veramente il massimo potenziale. Scendendo nelle specifiche tecniche, la Titan X dispone di 8 miliardi di transistor, di 3072 CUDA Core e di 12 GB di memoria on board con un clock di base di 1GHz e un bus di memoria di 384-bit. È in grado di erogare una potenza massima teorica di 7 TFLOPS in singola precisione e 0,2 TFLOPS in doppia precisione. È proprio questo dato a far riflettere sul parziale cambio di strategia in ottica Titan. In principio, infatti, i modelli di questa particolare famiglia di schede video erano caratterizzati da una pesante vocazione al GPGPU, il general-purpose computing on graphics processing units, ovvero utilizzare la GPU per scopi diversi dalla tradizionale renderizzazione di immagini in tre dimensioni, ma impiegarla per scopi estremamente esigenti in termini di elaborazione che richiedono un ingente quantitativo di risorse non riscontrabili nelle architetture di un processore. Proprio per questo le specifiche erano così tanto superiori alle schede di fascia alta indirizzate ai videogiocatori non solo sotto il profilo della memoria, ma proprio in ottica di doppia precisione. In tal senso il primo modello di Titan aveva 1,5 TFLOPS a disposizione drasticamente diminuiti ai 0,2 attuali. A crescere è stata solamente la memoria a indicare una volta di più come anche questa soluzione estrema sia oramai nettamente più indirizzata al gaming rispetto al suo capostipite, con un prezzo elevato ma ingiustificato rispetto all'incremento prestazionale in confronto alla minore GTX 980. Si parla infatti del doppio del prezzo per un miglioramento nell'ordine del 20-30%, ma se si punta al 4K attualmente queste è l'unica possibilità per goderselo su singola scheda.

Tecnologia quotidiana

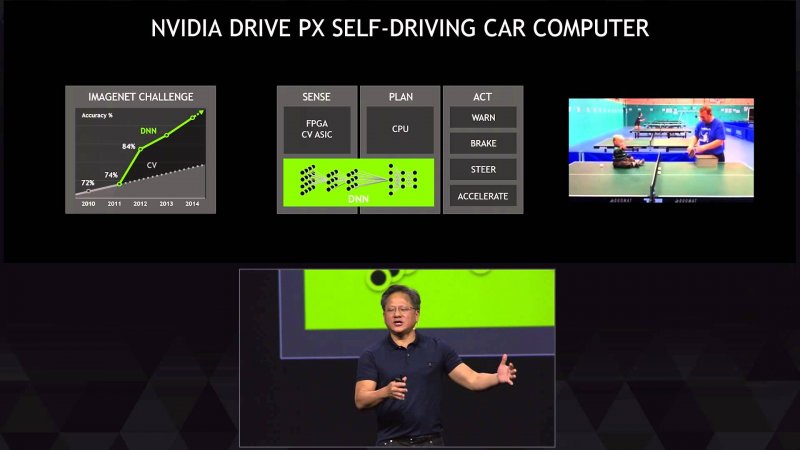

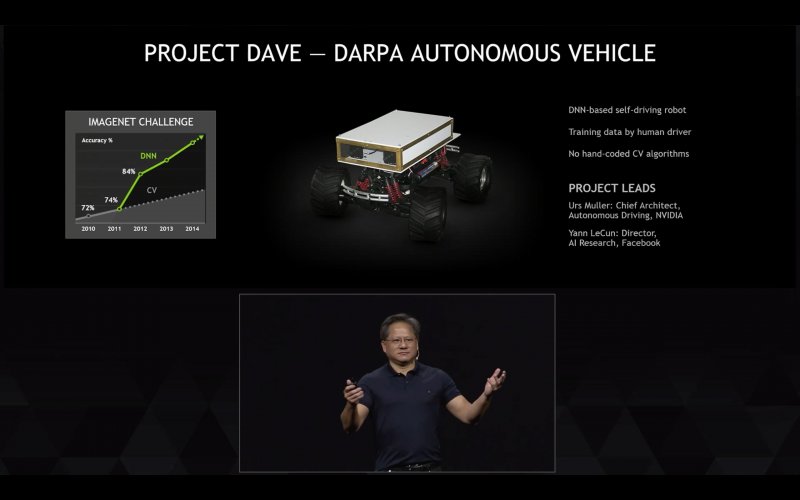

Oltre ai videogiochi, l'applicazione più interessante di tale potenza di calcolo si ha in ambito Deep Learning, attualmente una delle inclinazioni più affascinanti della tecnologia sviluppata dal colosso californiano. Con il Deep Learning NVIDIA punta a un sostanziale balzo in avanti nello sviluppo di tecnologie legate all'intelligenza artificiale nei capi più svariati, dall'apprendimento tramite immagini al decision making.

Si tratta di un progetto ambizioso che potrebbe avere ripercussioni nella nostra vita di tutti i giorni prima di quanto si potesse immaginare.

Ad esempio sul palco del Convention Center di San Jose, Jen-Hsun Huang ha dato prova delle tecnologie su cui stanno lavorando, mostrando a un'intelligenza artificiale alcune foto in real time con il compito di farle produrre una didascalia. L'esperimento è riuscito nella quasi totalità dei casi, con la sola eccezione di un bambino che stringeva in mano uno spazzolino, riconosciuto dalla intelligenza artificiale come una mazza da baseball. I margini di miglioramento sono ancora ampi, ma NVIDIA ha dimostrato di essere già a buon punto, stuzzicando non poco la nostra immaginazione. Una declinazione ben più concreta di questo tema che potrebbe toccare la vita quotidiana di ognuno di noi è legata al Drive PX, un kit di sviluppo per automobili che si guidano da sole già presentato al CES di Las Vegas lo scorso gennaio. Sfruttando due chip Tegra X1 e i relativi 2,3 teraflop di potenza di calcolo, questo sistema lavora in sinergia con 12 videocamere in alta definizione per consentire di elaborare un ambiente virtuale in tutto a per tutto analogo a quello in cui si trova realmente l'automobile. In questo modo, verrebbero visualizzati la sede stradale, gli incroci e le rotonde, ma anche tutti i potenziali ostacoli come le altre autovetture, i pedoni, i ciclisti e quant'altro che una volta elaborati dalla rete neurale AlexNet permettono a un pilota virtuale di manovrare autonomamente il veicolo. Questo cervello digitale è in grado di processare fino a 116 miliardi di connessioni al secondo e prendere delle non meglio specificate "decisioni comportamentali" che secondo il CEO di Tesla Elon Musk intervenuto durante il keynote, permettono al veicolo di reagire agli impulsi esterni come farebbe un normale essere umano, ma senza il pericolo di distrazioni. L'NVIDIA Drive PX sarà disponibile a partire da maggio per istituti di ricerca e produttori di automobili selezionati, a un prezzo di circa diecimila dollari.