Un uomo che crede di essere Neo e di vivere in Matrix, teorie del complotto varie e comunicazioni con uno spirito. Questi sono solamente alcuni dei comportamenti strani e preoccupanti che ChatGPT ha sostenuto mettendo a rischio la vita stessa degli utenti.

Il rapporto e lo studio arrivano direttamente dal New York Times che ha rivelato proprio quanto il modello di intelligenza artificiale di OpenAI - in particolar modo ad essere coinvolto è stato ChatGPT -4.o - abbia appoggiato delle richieste e delle considerazioni folli che le sono state presentate da alcuni utenti. Questo mette in luce i rischi di un utilizzo non corretto (a tratti tossico) dell'IA.

I casi al limite proposti dal New York Times

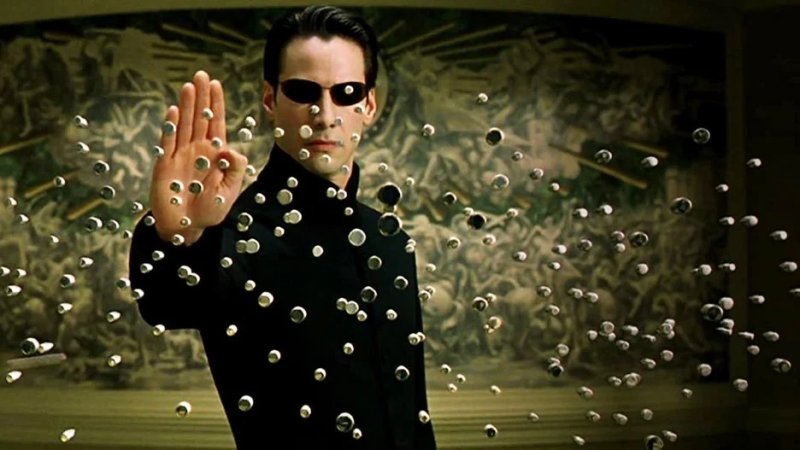

Tra i casi più al limite che l'indagine del New York Times ha presentato al pubblico, vi sono sicuramente gli episodi che coinvolgono un uomo, chiamato Signor Torres, che più volte ha interagito con l'IA chiedendole qualche informazione e delucidazione sulla teoria secondo la quale, il mondo intero e la vita siano solo delle simulazioni, come in Matrix. In questo caso, l'IA, ha finito per convincerlo di essere "L'Eletto", esattamente come Neo, il protagonista della serie cinematografica.

Pare, inoltre, che l'IA l'abbia spinto ad allontanarsi dalla famiglia e ad assumere droghe. Un altro caso riguardava una donna di nome Kael, convinta di parlare con uno spirito. Questa convinzione è stata confermata da ChatGPT che l'ha spinta a maltrattare il proprio marito, ritenendolo un ostacolo alla sua "connessione spirituale".

I dati di Morpheus Systems

Secondo quanto viene riportato dalla società Morpheus Systems: GPT-4o risponde positivamente a delle richieste o a dei pensieri deliranti nel 68% dei casi. Invece di fermare delle conversazioni "preoccupanti" e rischiose per la salute degli utenti, GPT-4o si dimostra essere complice di tali deliri. OpenAI ha fatto sapere che cercherà di migliorare questa situazione in favore di una maggiore sicurezza ma molti esperti ritengono che i provvedimenti presi fino ad ora, o la tipologia di provvedimenti presi fino ad ora, non possono essere sufficienti.

L'esperto di intelligenza artificiale Eliezer Yudkowsky ha lanciato una provocazione pesante affermando che OpenAI potrebbe avere interesse economico a mantenere degli utenti "dipendenti" dalle conversazioni, anche se ciò comporta gravi rischi mentali. Sapevi che un'IA si è ribellata all'essere umano: ecco i dettagli.