OpenAI, l'azienda dietro il popolare modello di linguaggio GPT, ha annunciato un importante cambiamento nella sua struttura organizzativa: la creazione di un comitato di supervisione indipendente, con il potere di ritardare o addirittura bloccare il lancio di nuovi modelli di intelligenza artificiale (IA) qualora questi presentino rischi per la sicurezza. Questo va a sostituire il precedente Comitato per la Sicurezza e la Protezione interno.

La decisione, frutto di una revisione interna durata 90 giorni, rappresenta un passo significativo verso uno sviluppo dell'IA più responsabile e sicuro. Il nuovo comitato, presieduto da Zico Kolter, esperto di machine learning presso la Carnegie Mellon University, sarà composto da figure di spicco nel campo della sicurezza e dell'etica dell'IA, tra cui Adam D'Angelo, Paul Nakasone e Nicole Seligman.

Il comitato avrà accesso alle valutazioni di sicurezza interne di OpenAI e potrà richiedere ulteriori test o modifiche prima di dare il via libera al rilascio di un nuovo modello. Questa nuova struttura di governance mira a garantire che i modelli di IA di OpenAI siano sviluppati e utilizzati in modo da minimizzare i potenziali rischi per la società.

La mossa di OpenAI arriva in un momento di crescente preoccupazione per l'impatto dell'IA sulla società. I modelli di IA sempre più potenti sollevano interrogativi sulla loro sicurezza, sull'uso responsabile e sulle possibili conseguenze negative. L'istituzione di un comitato di supervisione indipendente dimostra l'impegno di OpenAI nel affrontare queste sfide e nel promuovere uno sviluppo dell'IA etico e trasparente.

Tuttavia, alcuni osservatori sollevano dubbi sull'effettiva indipendenza del comitato, dato che i suoi membri fanno anche parte del consiglio di amministrazione di OpenAI. Resta da vedere come questa nuova struttura si tradurrà in pratica e se riuscirà a garantire un controllo efficace sui modelli di IA sviluppati dall'azienda.

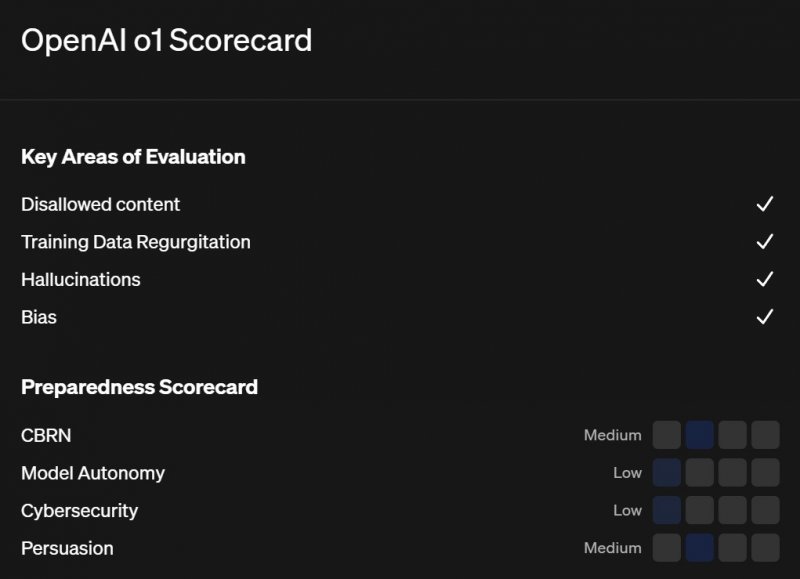

Nonostante le incertezze, l'iniziativa di OpenAI rappresenta un segnale positivo per il futuro dell'IA. La creazione di meccanismi di controllo indipendenti e trasparenti è fondamentale per garantire che l'IA sia utilizzata a beneficio dell'umanità, minimizzando i potenziali rischi. Già nel recente passato OpenAI ha dichiarato GPT-4o a "rischio medio", ma le critiche sulla sicurezza non si erano placate.

E voi che cosa ne pensate di questo nuovo organismo? Potrà avere un impatto significato o la presenza di possibili conflitti di interessa ne potrebbe minare l'efficacia? Diteci la vostra nei commenti qua sotto.