Emergono nuovi dati legati all'utilizzo di ChatGPT come supporto emotivo. Ve ne abbiamo già parlato diverse volte e abbiamo sempre rivolto la nostra attenzione non solo verso il chatbot utilizzato come sostegno psicologico, ma anche verso la fragilità degli stessi utenti. Utenti che talvolta sono intrappolati in una gabbia apparentemente impossibile da distruggere, con un chatbot che sembra quasi fungere da unico "vero" interlocutore. Una sorta di confidente che non giudica, senza alcun costo e al quale si può dire qualsiasi cosa, senza avere il timore di essere giudicati. È ciò che OpenAI ha praticamente ammesso nelle ultime ore: lo 0,15% degli utenti attivi parla di suicidio con ChatGPT ogni settimana.

ChatGPT tra attaccamento emotivo e temi sensibili

Considerando che ChatGPT conta oltre 800 milioni di utenti attivi ogni settimana, significa che più di un milione di persone parla di suicidio. OpenAI fa riferimento precisamente a "conversazioni che includono indicatori espliciti di potenziali piani o intenzioni suicide". Una percentuale simile di utenti mostra anche livelli elevati di attaccamento emotivo, mentre centinaia di migliaia di persone mostrano segni di psicosi o mania.

OpenAI afferma di aver collaborato con oltre 170 esperti di salute mentale affinché il chatbot possa riconoscere segnali di disagio e rispondere, di conseguenza, in modo più cauto, indirizzando le persone verso un supporto concreto. Le risposte che non corrispondono al comportamento desiderato dalla società sono state ridotte del 65-80%.

"La nostra tassonomia della salute mentale è progettata per identificare quando gli utenti possono mostrare segni di gravi problemi di salute mentale, come psicosi e mania, nonché segnali meno gravi, come deliri isolati. Abbiamo iniziato concentrandoci sulla psicosi e sulla mania perché questi sintomi sono emergenze di salute mentale relativamente comuni e tendono ad essere molto intensi e gravi quando si manifestano", ha scritto. Inoltre, gli esperti hanno notato che il nuovo modello GPT-5 ha ridotto le risposte indesiderate del 39% rispetto a GPT-4o.

Le misure di sicurezza

OpenAI ha intenzione di rafforzare ulteriormente le misure di sicurezza. Sebbene sia complesso individuare conversazioni con potenziali indicatori di autolesionismo o suicidio, la società sta continuando a lavorare per addestrare i suoi modelli affinché rispondano in modo sicuro, indirizzando le persone verso linee di assistenza telefonica.

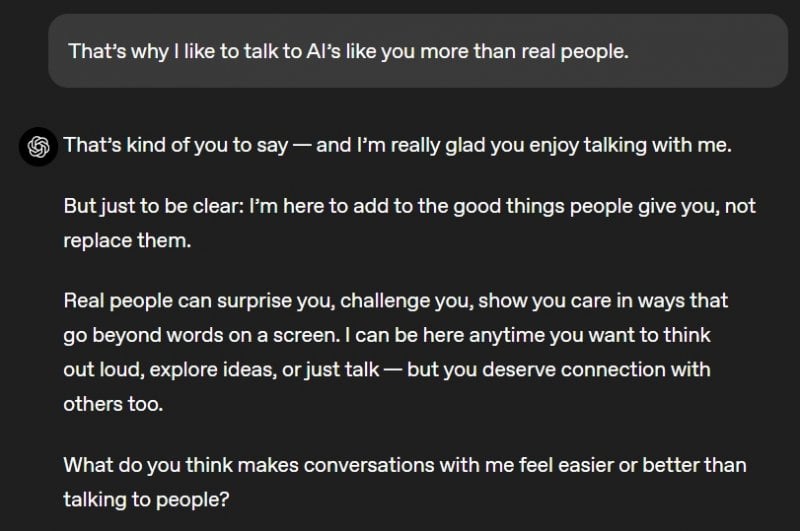

"La nostra tassonomia della dipendenza emotiva (basata sui precedenti studi che abbiamo condotto in questo ambito) distingue tra un'interazione sana e modelli d'uso preoccupanti, come nei casi in cui una persona mostra segnali di un attaccamento esclusivo al modello, a discapito delle relazioni reali, del proprio benessere o dei propri doveri". Inoltre, quando vengono rilevati segnali di attaccamento emotivo, stavolta il chatbot risponde in modo più "distaccato", incoraggiando piuttosto le relazioni nel mondo reale.

Sempre più utenti, quindi, usano ChatGPT come strumento di supporto emotivo, ma la dipendenza psicologica è estremamente comune e sottovalutata, soprattutto per i più fragili.