Apple ha annunciato un importante passo avanti nel campo dell'intelligenza artificiale applicata al video. I ricercatori dell'azienda hanno sviluppato SF-LLaVA-1.5, un modello linguistico multimodale capace di comprendere e descrivere filmati di lunga durata in modo più efficiente rispetto alle soluzioni precedenti. Si tratta di un'evoluzione di SlowFast-LLaVA, un modello open source che combina flussi di analisi "lenti" e "veloci" per catturare sia i dettagli statici delle scene sia i movimenti nel tempo.

Come funziona il modello

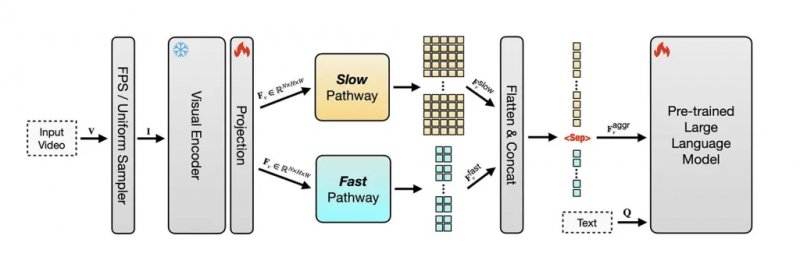

Il principio alla base è semplice ma potente: invece di analizzare ogni singolo frame - un processo ridondante e costoso - SF-LLaVA-1.5 seleziona 128 fotogrammi da qualsiasi clip, distribuendoli tra un flusso "slow" con 32 immagini ad alta definizione e uno "fast" con 96 frame a bassa risoluzione. In questo modo il modello evita di saturare la finestra di contesto degli LLM e riesce a mantenere l'attenzione su ciò che conta davvero.

Nonostante le dimensioni ridotte (1, 3 e 7 miliardi di parametri), SF-LLaVA-1.5 supera modelli molto più grandi in benchmark dedicati alla comprensione di video lunghi, come LongVideoBench e MLVU. Anche la versione più piccola da 1B ottiene risultati di rilievo, segno che l'efficienza del design ha un impatto concreto. Inoltre, il modello si comporta bene anche su compiti legati alle immagini, come OCR, ragionamento matematico e scenari ricchi di testo, superando una delle criticità tipiche dei Video LLM.

Limiti e prospettive future

Naturalmente non mancano i compromessi: il limite dei 128 frame può portare alla perdita di fotogrammi chiave o a una percezione distorta della velocità del video. I ricercatori ammettono che ulteriori miglioramenti potrebbero arrivare ottimizzando anche l'encoder visivo, ma i costi computazionali restano elevati. Tra le possibili soluzioni, viene citata l'integrazione di tecniche di risparmio memoria come lo Stochastic BP.

Uno degli aspetti più rilevanti è che SF-LLaVA-1.5 è stato addestrato esclusivamente con dataset pubblici ed è già disponibile come progetto open source su GitHub e Hugging Face. Con questa mossa, Apple si inserisce in modo più trasparente nel dibattito sull'AI generativa, offrendo alla comunità scientifica un modello potente, riproducibile e utilizzabile anche al di fuori dell'ecosistema proprietario.