Un nuovo capitolo nell'infrastruttura dell'intelligenza artificiale è stato aperto da Google, che ha annunciato il suo processore personalizzato Ironwood. Si tratta della settima generazione di unità tensoriali (TPU), ideata non tanto per l'addestramento dei modelli quanto per la loro esecuzione (inferenza) su scala industriale.

Il chip Ironwood è stato presentato ufficialmente da Google Cloud durante l'evento Cloud Next 2025.

I miglioramenti di Ironwood

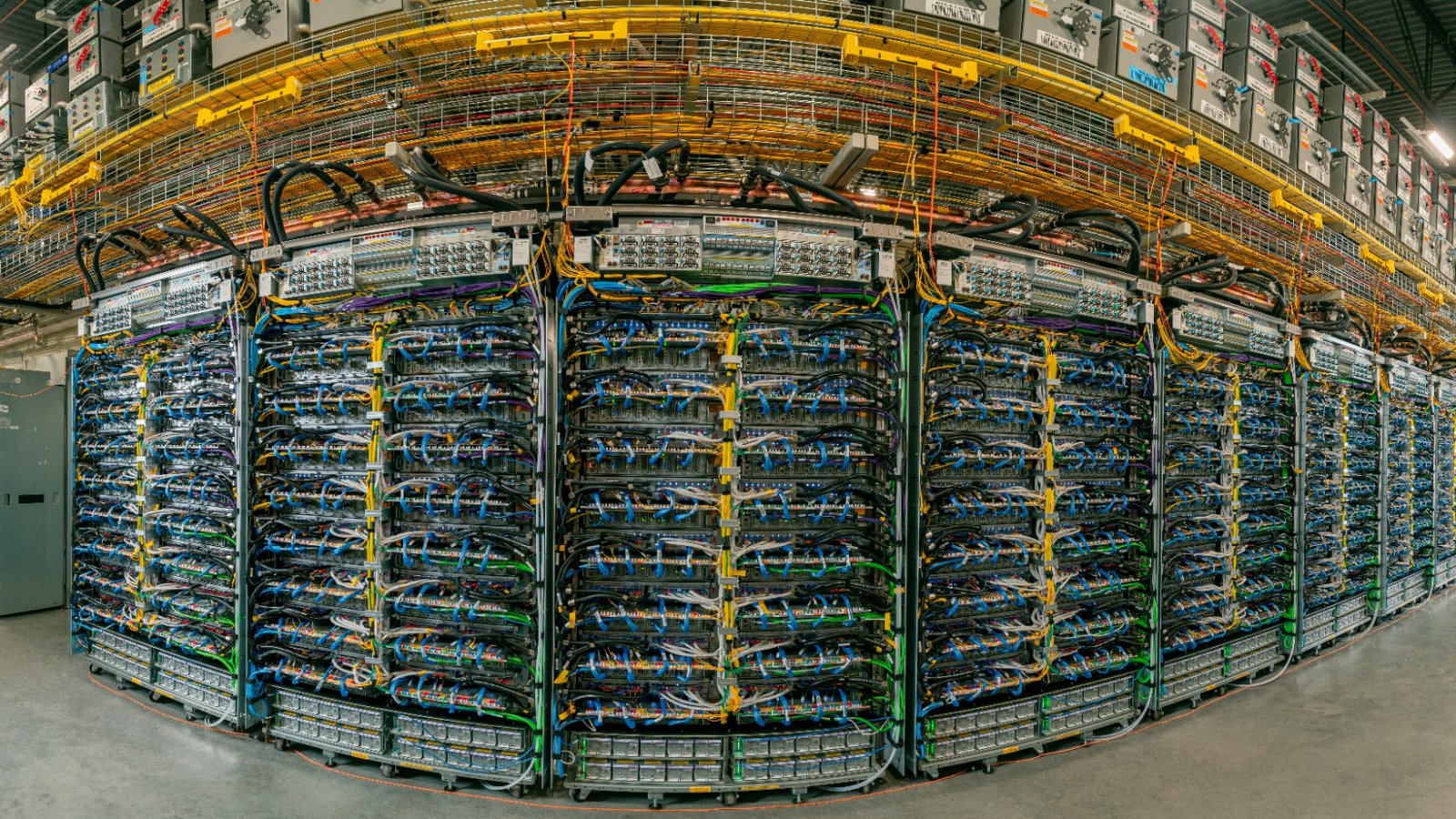

Secondo i dati pubblicati, rispetto alla generazione precedente (Trillium), Ironwood offre fino a cinque volte maggiore capacità di calcolo e sei volte la memoria ad alta larghezza di banda (HBM) per chip. Un aspetto rilevante è la configurazione di "superpod": il sistema può scalare fino a 9.216 chip collegati insieme, permettendo di raggiungere circa 42,5 exaflops di potenza di calcolo teorica complessiva.

Questa architettura include una memoria condivisa, tra i vari chip, dell'ordine di 1,77 petabyte, una soglia che stabilisce nuovi standard per i sistemi di calcolo distribuito. Dal punto di vista dell'efficienza energetica, Ironwood promette un miglioramento pari a circa 2 volte la prestazione per watt rispetto a Trillium.

Il design è costruito per l'inferenza - ossia l'esecuzione di modelli IA già addestrati - più che per l'addestramento puro. Google parla dell'inizio di una "era dell'inferenza" (age of inference), in cui l'IA non solo reagisce, ma genera ed interpreta in modo proattivo. Il chip integra anche avanzamenti nelle interconnessioni (inter-chip interconnect, o ICI) e tecnologie di raffreddamento a liquido per gestire il carico elevato di calcolo.

In termini di utilizzo, Google intende offrire queste TPU ai clienti della piattaforma Google Cloud, rendendo disponibile l'infrastruttura per carichi di lavoro IA complessi e su vasta scala. Dall'ottica del mercato, invece, l'ingresso della generazione Ironwood rafforza la posizione di Google nel panorama degli acceleratori IA e rappresenta un'alternativa concreta rispetto ai tradizionali fornitori di GPU. Inoltre, clienti di grandi dimensioni - ad esempio enti che gestiscono modelli di linguaggio - potranno beneficiare della maggiore efficienza e scala offerte da questa nuova architettura.

Intanto tutti vogliono i chip di AMD: dopo OpenAI sono in arrivo nuovi grandi partner per l'IA?